NeMo Guardrails - Mô hình 'cảnh sát AI' cần thiết trong giới công nghệ

Trước sự phát triển mạnh mẽ của công nghệ AI cũng như những tác động của mặt trái mà công nghệ mang đến cho con ngườn, phần mềm NeMo Guardrails được Nvidia phát triển để buộc các siêu AI không trả lời lan man, tự sáng tác, tránh chủ đề độc hại và loại bỏ câu lệnh nguy hiểm.

- Thí điểm nộp phạt vi phạm giao thông qua Cổng Dịch vụ công quốc gia

- Công nghệ AI - 'Làn gió mới' cho nền sản xuất của Đức

- Genetica: Ứng dụng trí tuệ nhân tạo (AI) trong phát triển công nghệ giải mã gene

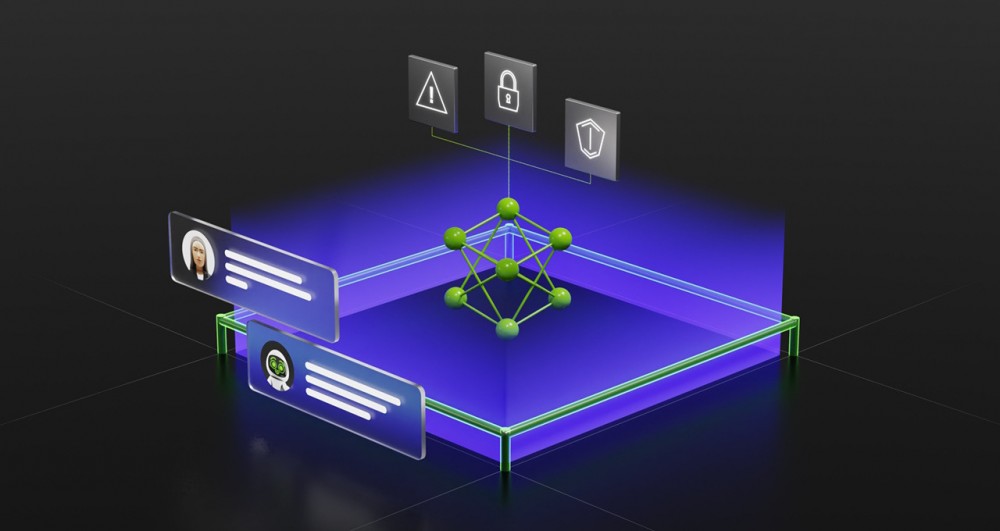

Theo đó, NeMo Guardrails là lớp phần mềm nằm giữa người dùng và mô hình ngôn ngữ lớn hoặc các siêu AI. Nó lọc những kết quả được cho là độc hại của AI, giảm khả năng đưa ra câu trả lời vô nghĩa, hoặc từ khóa xấu có thể xuất hiện trong dữ liệu học máy của các nền tảng.

Cohen lấy ví dụ một chatbot phục vụ khách hàng, được thiết kế để nói về sản phẩm của công ty, sẽ được NeMo Guardrails hạn chế tối đa việc nói về các sản phẩm của đối thủ cạnh tranh dù được khách hàng hỏi. Thậm chí, phần mềm có thể ngăn chatbot trả lời những câu liên quan đến nhân sự nội bộ và thông tin bảo mật của công ty.

"Cảnh sát AI" của Nvidia dùng một mô hình ngôn ngữ lớn khác để kiểm tra câu trả lời tự bịa của siêu AI. Nếu chatbot không đưa ra câu trả lời phù hợp, Nemo Guardrails sẽ không hiển thị nội dung đến người dùng. NeMo Guardrails được cung cấp dưới dạng nguồn mở thông qua các dịch vụ của Nvidia và có thể dùng trong ứng dụng thương mại.

NeMo Guardrails được xem như mô hình cần thiết để có thể đảm bảo sự an toàn của con người trong trào lưu sử dụng và sự phát triển vượt bậc của AI.

Các công ty AI như Google, OpenAI, Microsoft cũng đang ngăn AI tự bịa nội dung hoặc nói thông tin độc hại bằng cách để con người "dạy" AI. Tuy nhiên, điều này cũng gây nên một làn sóng tranh cãi về đạo đức nghề nghiệp và rủi ro liên quan đến vấn đề thiên vị giới tính, sắc tộc.

Phần mềm NeMo Guardrails, được Nvidia công bố hôm 25/4, được đánh giá là một trong những bước tiến quan trọng của trí tuệ nhân tạo nhằm giải quyết vấn đề siêu AI bị "ảo giác" - vấn đề lớn mà những mô hình AI tạo sinh như GPT của OpenAI hay LaMDA của Google đang gặp phải.

Các siêu AI như ChatGPT, Bard được đào tạo trên hàng terabyte dữ liệu để trả lời như con người. Tuy nhiên, chúng có một xu hướng xấu là có thể bịa ra nội dung. Trong cuộc phỏng vấn với CBS tuần trước, CEO Google Sundar Pichai thừa nhận ngay cả hãng cũng không hiểu đầy đủ về AI khi nó có thể tạo ra câu trả lời có phần ngớ ngẩn, thậm chí nguy hiểm.

NeMo Guardrails có thể giảm thiểu các câu trả lời tự bịa bằng cách thêm nhiều lớp ngăn AI nói ra chủ đề ngoài tầm hiểu biết. Phần mềm mới buộc chatbot chỉ nói về một chủ đề cụ thể, loại bỏ nội dung độc hại và hạn chế việc thực thi các lệnh có hại trên máy tính.

"Một siêu AI cần được mã hóa cứng trong các logic thực thi của hệ thống bảo vệ, đảm bảo không nói luyên thuyên những thứ ngoài chủ đề người dùng đang đề cập hoặc nhắc đến nội dung độc hại", Jonathan Cohen, Phó chủ tịch nghiên cứu ứng dụng của Nvidia, nói.

Trong lĩnh vực phần cứng, Nvidia hiện chiếm hơn 95% thị trường chip đào tạo AI và đang cung cấp hàng nghìn bộ xử lý đồ họa cần thiết để xây dựng những siêu AI như ChatGPT.

Theo tạp chí Điện tử và Ứng dụng